Apache Spark와 Hadoop 공부 시작

Apache Spark

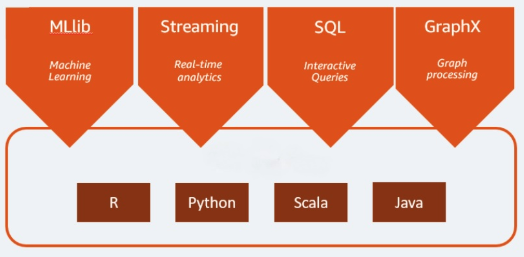

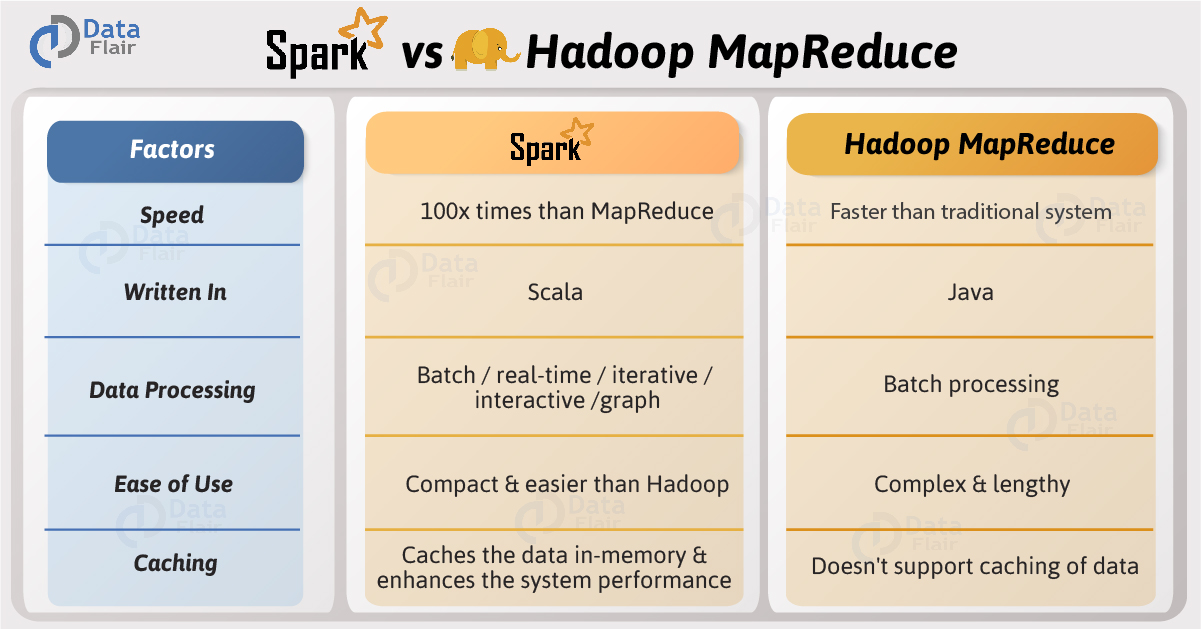

- Apache Spark가 scala로 되어있어서 api가 scala로 제일 먼저 나옴

- Apache Spark는 빅데이터를 처리하기 위한 sw platform

- 빅데이터란?

- 한 컴퓨터로 처리할 수 없는 양의 데이터

- 빅데이터란?

- Apache Spark는 기본적으로 여러 대의 서버를 활용

- Apache Spark는 여러대의 서버를 한대에서 실행하는 것처럼 작업할 수 있도록 해줌

- Apahce Spark의 엔진이 Hash방법으로 알아서 여러대로 분산을 시켜줌

Hadoop

- HDFS (Hadoop Distributed File System) - Google File System 논문을 base로 open-source로 만든 file system

- MR

- MapReduce - Hadoop이 나온지 얼마되지 않았을 때는 Map과 Reduce만 가능

- 지금은 Hadoop내에서 Spark연산이 가능

- YARN - Yet Another Resource Negotiator : Memory와 CPU를 위해서 싸우는 것들의 협상자

- ‘Mem 얼마, CPU 얼마가 필요해’ says App –> ‘Server x, y를 가서 쓰렴’ says YARN

- 더 이상 할당해줄 수 있는 memory와 cpu가 없으면, pending 시킴

- 내부적으로 어떤 식으로 data 작업이 실행이 되었는지 시각화를 해줌

- default로 3개의 복사본을 자동으로 만들어줌으로 데이터 손실을 막아줌

엄청 어려워보이지만 잘 지내보자 :)